[KBS 부산] 우리 생활 곳곳에 스며들고 있는 AI 기술을 알기 쉽고 재미있게 전해드리는 '아핫 AI' 시간입니다.

'흑인은 음악을 잘한다' '동양인은 수학을 잘한다' 정확한 사실을 모른 채 내리는 판단을 '편견'이라고 하죠.

우리는 일상 속에서 종종 '편견'과 마주하게 됩니다.

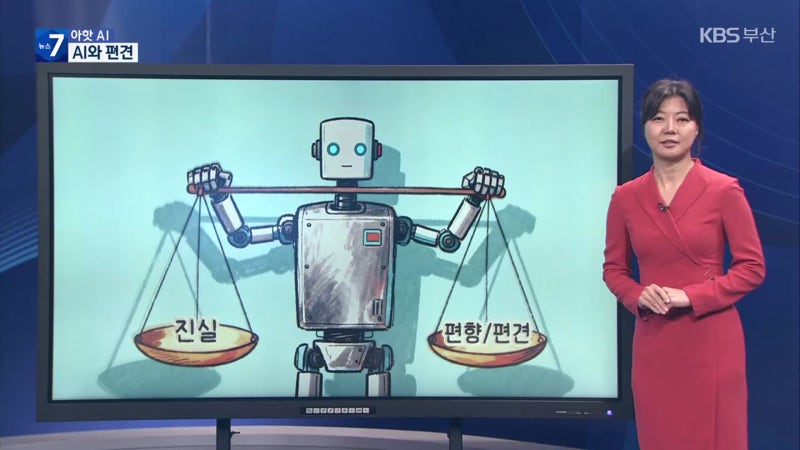

그런데 인공지능은 편견에서 자유로울 수 있을까요?

기계니까 감정이 없고, 사람보다 더 객관적일 것이라고 생각하기 쉽지만 현실은 그렇지 않습니다.

인공지능 이미지 생성기 '스테이블 디퓨전'에 최고경영자, 가정부 등을 검색하면 최고경영자는 주로 백인 남성, 가정부는 제3세계 여성으로 표현됐습니다.

수많은 데이터를 학습하는 AI가 사회 속 고정관념까지 그대로 배운 결과죠.

이런 편향은 이미 여러 차례 문제로 지적돼 왔습니다.

2015년 구글의 이미지 분류 시스템은 한 흑인 사용자의 사진을 '고릴라'로 잘못 분류해 논란이 됐습니다.

또 미국 민간기업이 개발한 재범 예측 프로그램 '콤파스'는 범죄 전력과 범죄자의 성향, 태도 등 130개가 넘는 요소를 토대로 재범 위험을 10단계로 평가했는데요.

백인보다 흑인의 재범 확률을 높게 예측하는 편향된 결과를 내놓았습니다.

AI가 가지는 편견 문제는 성별에서도 자주 드러납니다.

애플의 시리나 아마존의 알렉사처럼 AI 비서의 목소리가 대부분 여성으로 설정된 것도, '비서는 여성일 것'이라는 사회적 인식이 반영된 결과라는 지적이 따릅니다.

또 아마존은 과거 데이터를 학습한 AI 채용 시스템을 만들었는데요.

이 시스템이 대부분 남성만 추천하고 여성 지원자에게 불이익을 주는 판단을 내리자 결국 이 시스템을 폐기하기도 했습니다.

지식 편향의 문제도 있습니다.

최근 네이버 AI 검색이 '일본 영토'를 묻는 질문에 독도를 포함한다는 대답을 내놔 논란이죠.

AI가 국가별 자료의 비중을 구분하지 못하고 일본 측 서술을 사실로 인식했기 때문입니다.

문제를 인식하고 고쳐 나가려는 노력도 이어지고 있습니다.

국내 한 AI 기술 기업은 얼굴 표정과 움직임을 인식하는 AI를 개발하는 과정에서 특정 인종이나 얼굴형을 제대로 인식하지 못하는 문제를 발견했습니다.

이에 데이터를 다시 정비하고 다양한 인종과 표정을 고르게 학습시키는 방식을 적용했죠.

그 결과 AI의 인식 정확도와 표현력이 이전보다 훨씬 높아졌습니다.

AI는 '객관적인 기계'가 아닙니다.

우리가 살아가는 사회의 불균형을 그대로 학습하고, 때론 더 크게 증폭시키기도 하죠.

기술의 발전만큼 중요한 건 그 기술이 공정하게 작동하도록 감시하고 바로잡는 일입니다.

편향 없는 AI를 만들기 위한 노력, 이제는 기술자만의 몫이 아닌 우리 모두의 몫입니다.

아핫, AI였습니다.

댓글목록

등록된 댓글이 없습니다.